Autor

En los últimos tres años, los Large Language Models (LLMs) han pasado de ser un experimento prometedor a convertirse en una herramienta estratégica para la industria tecnológica. Desde la llegada de GPT‑3, el interés por esta tecnología se ha multiplicado, impulsado por casos de uso que prometen transformar la productividad en desarrollo de software, servicios legales, análisis de datos y más.

Pero más allá del hype y de las promesas exageradas, el verdadero valor de los LLMs está en cómo se implementan y en qué datos se apoyan.

De predictores de palabras a asistentes inteligentes

Aunque se hable de ellos como “inteligencia artificial”, un LLM no razona: predice la siguiente palabra en función del contexto que recibe. Esta limitación técnica no impide que, con el diseño adecuado, se convierta en un asistente de decisiones inteligente capaz de:

-

Generar insights relevantes a partir de datos existentes.

-

Agilizar el desarrollo de software y optimizar código.

-

Adaptarse a preferencias específicas de un equipo de desarrollo.

La clave está en alimentarlo con información relevante y específica, en lugar de esperar que un modelo genérico pueda resolver problemas internos de negocio por sí solo.

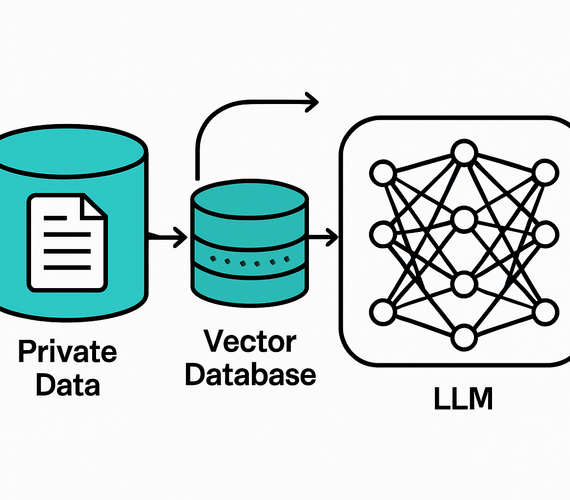

El reto: conectar un LLM con datos propios

Un modelo preentrenado desconoce la base de conocimiento privada de una empresa. Para hacerlo realmente útil, es necesario dotarlo de acceso controlado a esos datos.

Aquí entra en juego una técnica esencial: Retrieval‑Augmented Generation (RAG).

RAG permite:

-

Vectorizar documentos internos (manuales, especificaciones, playbooks) mediante modelos de embeddings.

-

Indexar esos vectores para búsquedas rápidas y precisas.

-

Recuperar sólo la información relevante para cada consulta.

Con este enfoque, un LLM puede responder a preguntas específicas sobre datos privados sin almacenar ni aprender esa información, garantizando seguridad y reduciendo el consumo de tokens.

Chunks y búsquedas rápidas

Para que el modelo procese información extensa, los documentos se dividen en fragmentos (chunks).

-

Estos pueden definirse por número fijo de caracteres o mediante estrategias dinámicas.

-

Cada chunk se convierte en un vector, lo que permite búsquedas ultrarrápidas usando métricas como la similitud de coseno.

De esta forma, en lugar de buscar en miles de páginas de texto, el modelo busca en un espacio vectorial optimizado y devuelve las coincidencias más relevantes.

Productividad real: ejemplos en desarrollo de software

Cuando un LLM conoce el stack tecnológico y las preferencias de un equipo, su capacidad de aporte se multiplica:

-

Refactoriza código siguiendo las mejores prácticas internas.

-

Renombra variables y aplica patrones de diseño coherentes.

-

Genera documentación de métodos y clases de forma automática.

-

Acelera el onboarding de desarrolladores junior al explicar el código adaptado al contexto del proyecto.

En pruebas internas, este tipo de integración ha permitido aumentar la productividad entre un 30 % y un 40 %, especialmente en tareas repetitivas y de bajo valor creativo.

Más allá del software: casos cross‑industry

El potencial de los LLMs no se limita al código. En departamentos legales, por ejemplo, pueden analizar contratos para identificar cláusulas presentes, ausentes o incompletas. Un proceso que antes tomaba semanas puede resolverse en menos de dos minutos.

En entornos industriales, los LLMs se usan para interpretar logs de sistemas, optimizar flujos de trabajo y servir como interfaz de consulta entre diferentes plataformas.

Un futuro asistido por IA

La proyección es clara: entre 2030 y 2060, gran parte de las tareas profesionales estarán automatizadas o asistidas por IA. En el desarrollo de software, esto no significa reemplazo del humano, sino desarrolladores aumentados capaces de producir más, con menos errores y en menos tiempo.

La lección es simple: un LLM genérico tiene valor limitado. Un LLM alimentado con datos propios, configurado para el contexto correcto y respaldado por técnicas como RAG se convierte en un activo estratégico que acelera procesos, mejora calidad y libera el verdadero potencial de la inteligencia artificial aplicada.

Si quieres aprender más de casos de uso de ciencia de datos e IA, no te pierdas el próximo Data Day y mira el video completo de esta charla:

Autor

- Log in to post comments